طبیعی است که شور و شوق برای این ابزارها افزایش یابد، چراکه حتی سریعتر از اینترنت یا رایانههای شخصی بهکار گرفته شدند. اما کارشناسان هشدار میدهند که باید محتاط باشیم. مانند هر فناوری جدید، هوش مصنوعی مولد میتواند جامعه را به جلو ببرد، اما اگر بدون نظارت رها شود، پیامدهایی به همراه خواهد داشت.

یکی از این صداها ناتاشا گووندر-روپرت، رئیس بخش هوش مصنوعی در حوزه جرائم مالی در بانک Rabobank است. او در تازهترین قسمت از برنامه «رانندگی بزرگ بعدی کیا» در کنار بوریس فلدهایزن فن زانتن (بنیانگذار TNW) درباره اخلاق هوش مصنوعی، تعصب الگوریتمی و اینکه آیا ما در حال واگذاری مغزمان به ماشینها هستیم یا نه، صحبت کرد.

مغز شما و هوش مصنوعی مولد

پرسشی که باید مطرح شود این است: وقتی هر روز بیشتر به هوش مصنوعی مولد برای یافتن پاسخ تکیه میکنیم، این وابستگی چه تأثیری بر هوش ما دارد؟

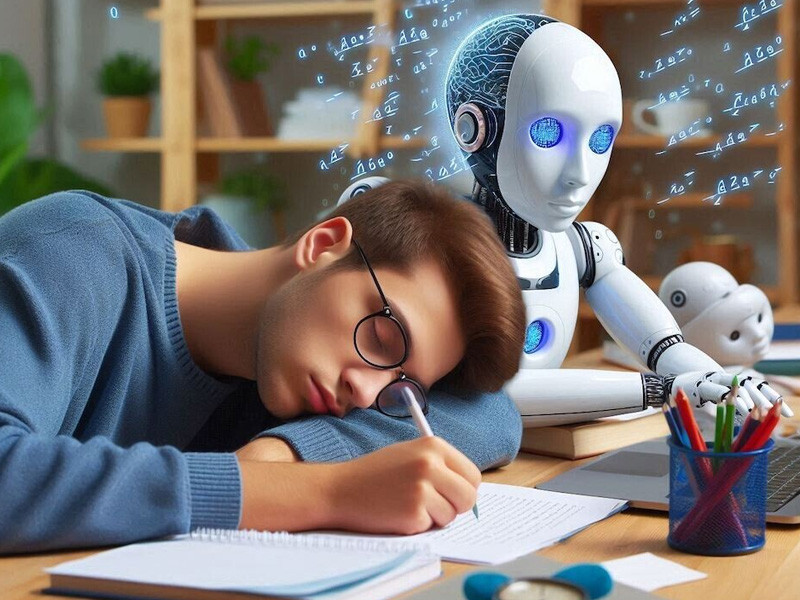

یک مطالعه اخیر در MIT درباره استفاده از ChatGPT برای نوشتن انشا، سرخطهای جنجالی بسیاری ایجاد کرد:

«محققان میگویند استفاده از ChatGPT میتواند مغزتان را فاسد کند» یا «ChatGPT ممکن است شما را تنبل و کمهوش کند.» اما واقعیت چیست؟

در آزمایش، ۵۴ دانشجو از منطقه بوستون به سه گروه تقسیم شدند:

-

گروه اول از ChatGPT استفاده کردند.

-

گروه دوم از گوگل (بدون کمک هوش مصنوعی) استفاده کردند.

-

گروه سوم فقط با فکر خود نوشتند.

فعالیت مغزی آنها با الکترود اندازهگیری شد. پس از سه جلسه، گروه «مغز تنها» بالاترین سطح ارتباطات ذهنی را نشان دادند. گروه ChatGPT پایینترین. یعنی کاربران هوش مصنوعی روی «خلبان خودکار» بودند، در حالیکه دیگران برای نوشتن باید بیشتر فکر میکردند.

در دور چهارم، نقشها عوض شد. گروه «مغز تنها» این بار مجاز به استفاده از ChatGPT شد و گروه AI مجبور شد بهتنهایی بنویسد. نتیجه؟ گروه اول انشای بهتری نوشتند؛ گروه دوم حتی به خاطر نمیآوردند قبلاً چه نوشته بودند.

در مجموع، طی چهار ماه مطالعه، گروه «مغز تنها» از نظر عصبی، زبانی و رفتاری عملکرد بهتری داشتند. کاربران ChatGPT زمان کمتری صرف نوشتن کردند و بیشتر به کپی/پیست بسنده نمودند. معلمان زبان انگلیسی آثار آنها را فاقد اندیشه اصیل و «روح» توصیف کردند.

اما پژوهشگران تأکید کردند یافتهها بیشتر درباره «میانبرهای ذهنی» است تا «زوال مغزی». یعنی استفاده بیرویه از LLMها باعث کاهش درگیری ذهنی میشود، اما استفاده فعال و آگاهانه میتواند این خطر را کاهش دهد. افزون بر این، مطالعه بسیار کوچک و محدود بود و نتیجهگیری قطعی از آن درست نیست.

مرگ تفکر انتقادی؟

این یافتهها (که هنوز داوری همتا نشدهاند) نشان میدهند باید بیشتر درباره نحوه استفاده از LLMها در آموزش، کار و زندگی بیندیشیم. شاید چیزی که واقعاً مغزمان را از بین میبرد نه خود ChatGPT بلکه تیترهای اغراقآمیز برای کلیک باشد.

پژوهشگران حتی یک وبسایت و صفحه پرسشهای متداول ایجاد کردند تا خبرنگاران را از بزرگنمایی منع کنند. آنها گفتند بسیاری از «سر و صدا»ها ناشی از آن بود که خبرنگاران برای خلاصهسازی مقاله از LLMها استفاده کرده بودند.

دو نتیجه روشن از این مطالعه:

-

باید پژوهشهای بیشتری درباره نقش LLMها در آموزش انجام شود.

-

همه ما باید در برابر اطلاعاتی که از رسانهها یا هوش مصنوعی دریافت میکنیم، دیدی انتقادی داشته باشیم.

پژوهشگران دانشگاه آزاد آمستردام هشدار میدهند که افزایش اتکای ما به LLMها میتواند تفکر انتقادی را تضعیف کند:

«دانشجویان ممکن است کمتر به جستوجوی گسترده و جامع بپردازند چون به لحن مقتدر و مطلع هوش مصنوعی اعتماد میکنند. آنها ممکن است کمتر به چشماندازهای نادیده گرفتهشده توجه کنند یا مفروضات پنهانی که پشت ادعاهاست را زیر سؤال ببرند.»

این خطر به مشکل عمیقتری در هوش مصنوعی اشاره دارد: اگر خروجیهایش را بدون پرسش بپذیریم، تعصبات و پیشفرضهای تثبیتشده را نادیده خواهیم گرفت.

نقش انسان در تعریف تعصب

گووندر-روپرت، که بر ساخت هوش مصنوعی مسئولانه تمرکز دارد، گفت:

«تعصب تعریف یکسانی ندارد. چیزی که من مغرضانه میدانم ممکن است از نظر فرد دیگر بیطرفانه باشد. این ما انسانها هستیم که باید تصمیم بگیریم و مجموعهای از اصول را برای دادههایمان تعریف کنیم.»

هنجارهای اجتماعی و سوگیریها ثابت نیستند، بلکه همواره در حال تغییرند. اما دادههای تاریخی که LLMها بر اساس آنها آموزش میبینند، تغییر نمیکنند. بنابراین ما باید همواره منتقد باقی بمانیم و اطلاعاتی را که از انسان یا ماشین میگیریم به چالش بکشیم تا جامعهای عادلانهتر و برابرتر بسازیم.